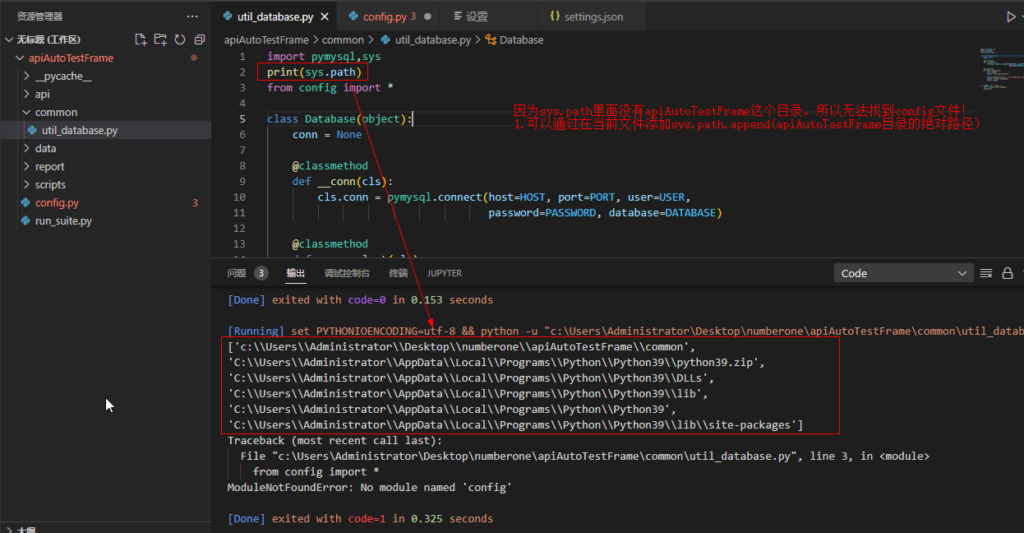

问题背景

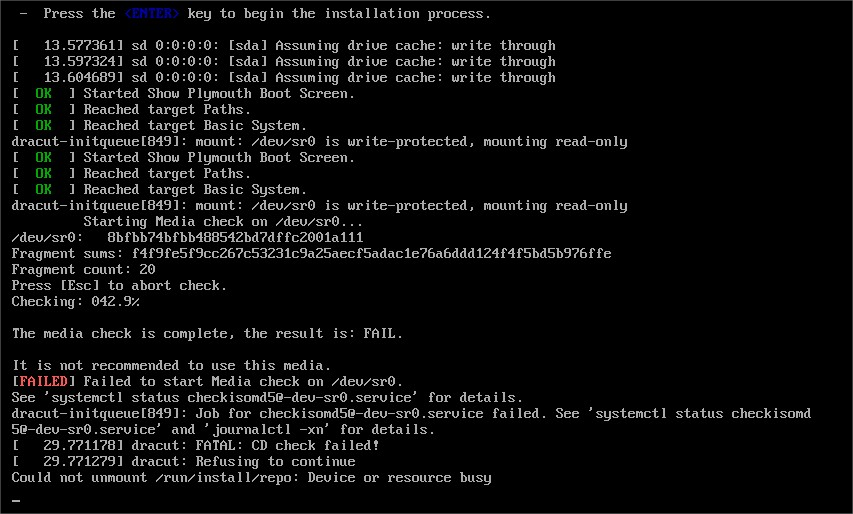

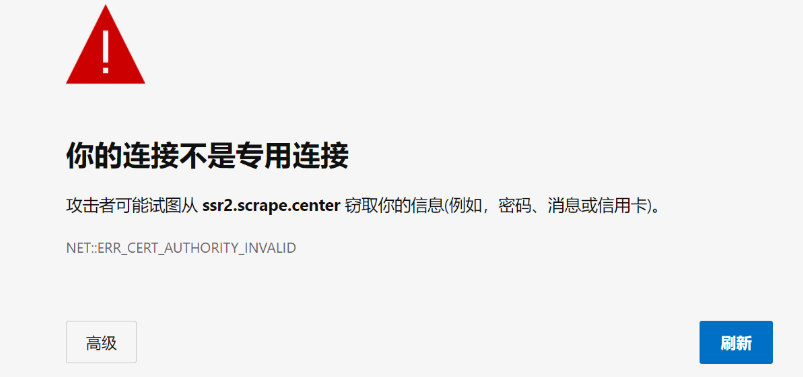

如果目标网站没有设置好HTTPS证书,又或者网站的HTTPS证书不被CA机构认可,用浏览器访问的话,就可能会出现SSL证书错误的提示。

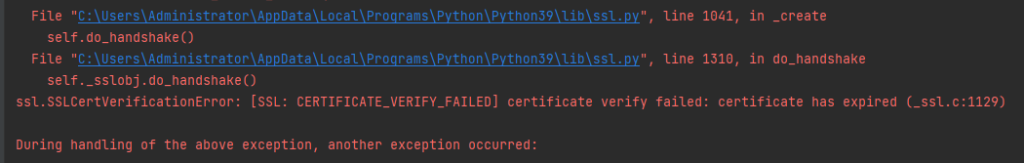

用requests库来请求这类网站的话,会直接抛出SSLError错误。

解决办法

方法一:最方便的手段是直接设置不验证,即:

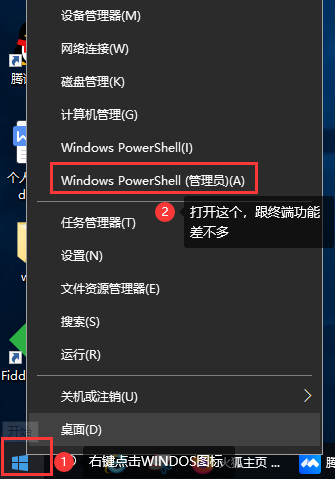

requests.get('https://example.com', verify=False) # 设置verify=False方法二:全局取消证书验证,简易方便,但对整个项目可能会出现安全性的相关问题。

import ssl

ssl._create_default_https_context = ssl._create_unverified_context方法三:urllib2.urlopen 的传参

context = ssl._create_unverified_context()

urllib2.urlopen(context=context)解决警告

不过,返回的结果还是会带上一个丑了吧唧的警告(建议给它指定证书),如果想眼不见为净的话,有三个选择

1.直接设置忽略警告

import requests

from requests.packages import urllib3

urllib3.disable_warnings()

r = requests.get('https://ssr2.scrape.center/', verify=False)

print(r.status_code)2.通过捕获警告到日志的方式来忽略警告

import requests

import logging

logging.captureWarnings(True)

r = requests.get('https://ssr2.scrape.center/', verify=False)

print(r.status_code)3.也可以指定一个本地证书用作客户端证书(这可以是单个文件,也可以是一个包含两个文件路径的元组)

import requests

r = requests.get('https://ssr2.scrape.center/', verify=False, cert=('/path/server.crt', '/path/server.key'))

print(r.status_code)© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END